V loňském roce program umělé inteligence nazvaný AlphaGo vytvořený týmem společnosti DeepMind společnosti Google porazil lidského mistra v Go, starověké čínské strategické hře, která je v mnoha ohledech složitější než šachy. Jak Emily Matchar v té době reportovala na Smithsonian.com, byl to ohromující úspěch, protože až v roce 1997 někteří lidé předpovídali, že bude trvat 100 let, než počítač porazí člověka na Go.

Zatímco výkon je působivý, AlphaGo se naučil hrát hru analýzou předchozích her hraných lidmi. Ale jak uvádí Merrit Kennedy ve zprávě NPR, nová verze umělé inteligence s názvem AlphaGo Zero přišla na to, jak zvládnout hru sama o sobě, bez lidského vstupu nebo manipulace - pokrok, který má velké důsledky pro budoucí vývoj AI.

Podle tiskové zprávy společnosti DeepMind se předchozí verze AlphaGo naučily hrát hru studováním zápasů mezi profesionálními a silnými amatérskými hráči, absorbováním pravidel hry a úspěšnými strategiemi hry. AlphaGo Zero se však nedíval na žádné hry hrané lidmi. Namísto toho dostala pravidla hry a poté hrála proti sobě, pomocí posilovacího učení se naučila správným a špatným pohybům a dlouhodobým strategiím. Když AI hrál hru, aktualizoval svou pokročilou neuronovou síť, aby lépe předpovídal pohyby soupeře.

Vědci sledovali, jak AI zvládne hru v reálném čase. Po třech dnech se podařilo porazit předchozí verzi s názvem AlphaGo Lee, která porazila korejského Go mistra Lee Sedol ve 4 z 5 her v roce 2016. Po 21 dnech to nejlepší AlphaGo Master, verzi, která porazila 60 nejlepších hráčů Go online a nejlepší světový hráč Ke Jie začátkem tohoto roku. Nejnovější verze přiblížila hry AlphaGo Master 100 na 0. Po 40 dnech dosáhla úrovně hry, kterou nikdo předtím neviděl. Výzkum se objevuje v časopise Nature.

"V krátké době, AlphaGo Zero pochopil všechny Go znalosti, které byly nahromaděny lidmi po tisíce let hraní, " vedoucí výzkumník David Silver z Google DeepMind říká v YouTube video. "Někdy je vlastně rozhodnuto jít za to a objevit něco, co lidé v této době ani neobjevili, a objevili nové poznatky, které jsou mnoha způsoby kreativní a nové."

Jak uvádí agentura Agence France-Presse, AlphaGo Zero dosáhlo této úrovně mistrovství mnohem efektivněji než její předchůdci. Zatímco předchozí iterace měla 48 jednotek pro zpracování dat a během několika měsíců hrála 30 milionů tréninkových her, Zero měla pouze 4 jednotky a během tří dnů hrála 4, 9 milionu tréninkových her. "Lidé mají tendenci předpokládat, že strojové učení je hlavně o velkých datech a obrovském množství výpočtů, ale ve skutečnosti to, co jsme viděli s AlphaGo Zero, je to, že na algoritmech záleží mnohem více, " říká Silver AFP.

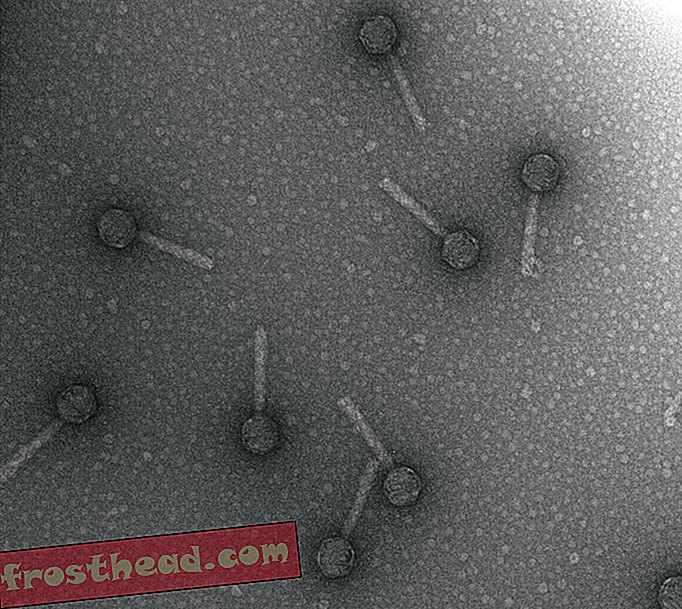

Výzkum je však více než jen zvládnutí deskové hry. Jak Ian Sample ve zprávách The Guardian uvádí, že tento typ tabula rasa nebo prázdná břidlice, učení by mohlo vést k nové generaci umělé inteligence pro všeobecné účely, která by mohla pomoci vyřešit problémy v oblastech, které lze dobře simulovat v počítači, jako je složení drog, složení bílkovin nebo fyzika částic. Budováním svých znalostí od základů bez předpojatostí nebo omezení člověka by algoritmy mohly jít ve směru, o kterém si lidé ještě neuvědomili, že se budou dívat.

Zatímco mnoho lidí v AI komunitě vidí AlphaGo Zero jako velký úspěch, Gary Marcus, profesor psychologie na New York University, který se specializuje na umělou inteligenci, říká NPR Kennedymu, že si nemyslí, že tento algoritmus je opravdu tabula rasa, protože předchozí lidské znalosti šly do konstrukce algoritmu. Také si nemyslí, že AI tabula rasa je tak důležitá, jak se zdá. "[V] biologii nejsou skutečné lidské mozky tabula rasa ... nevidím hlavní teoretický důvod, proč byste to měli dělat, proč byste měli opustit spoustu znalostí, které o světě máme, " říká.

Přesto je rychlé zvládnutí hry Alpha Go působivé - a trochu děsivé.