Stejná technologie, která pohání vášnivého mobilního asistenta, může jednoho dne poskytnout hlas těm, kteří ztratili schopnost mluvit. Jak Renae Reints hlásí Fortune, neurovědci z Columbia University nedávno dosáhli významného pokroku směrem k tomuto futuristickému cíli a poprvé úspěšně převedli mozkové vlny do srozumitelné řeči.

Výzkum týmu, publikovaný ve vědeckých zprávách, zahrnuje poněkud netradiční přístup. Namísto přímého sledování myšlenek k produkci řeči vědci zaznamenávali neurologické vzorce generované testovanými subjekty, které poslouchají ostatní. Tyto mozkové vlny byly přiváděny do vocoderu - algoritmu umělé inteligence, který syntetizuje řeč - a poté převedeny na srozumitelné, byť roboticky znějící řeči, které odrážejí fráze slyšené účastníky.

"Naše hlasy nám pomáhají spojit se s našimi přáteli, rodinou a světem kolem nás, a proto je ztráta síly hlasu kvůli zranění nebo nemoci tak zničující, " říká autor studie Nima Mesgarani, inženýr v Columbiaově neurobiologickém programu, říká v prohlášení. "Díky dnešní studii máme potenciální způsob, jak tuto moc obnovit." Ukázali jsme, že se správnou technologií mohou myšlenky těchto lidí dekódovat a porozumět jim každý posluchač. “

Podle Gizmodova George Dvorského stojí za zmínku, že vědci dosud nepřišli na to, jak přímo převést vnitřní myšlenky, známé také jako imaginární řeč, do slov. V tomto ideálním scénáři by jednotlivci používající technologii řeči jednoduše představili, co chtěli říci, a pak počkali, až si umělé hlasové systémy tyto myšlenky verbalizují.

Pozdní britský fyzik Stephen Hawking používal základní verzi technologie syntézy řeči ke komunikaci s ostatními. Jak Nina Godlewski píše pro Newsweek, Hawkingovi byla diagnostikována amyotropní laterální skleróza (ALS) ve věku 21 let. Nemoc motorických neuronů si nakonec vyžádala jeho řečové schopnosti, což ho přinutilo používat ke spouštění řeči ruční klikání.

Když Hawking ztratil použití rukou, přešel na systém založený na pohybech obličeje; Gizmodův Dvorský dále vysvětluje, že vědec použil lícní přepínač připojený k jeho brýlím, aby vybral slova vyslovená hlasovým syntetizátorem.

Pokročilá iterace této technologie by vynechala prostředníka a umožnila by uživatelům vytvářet řeč bez pomoci počítače nebo systému citlivého na pohyb.

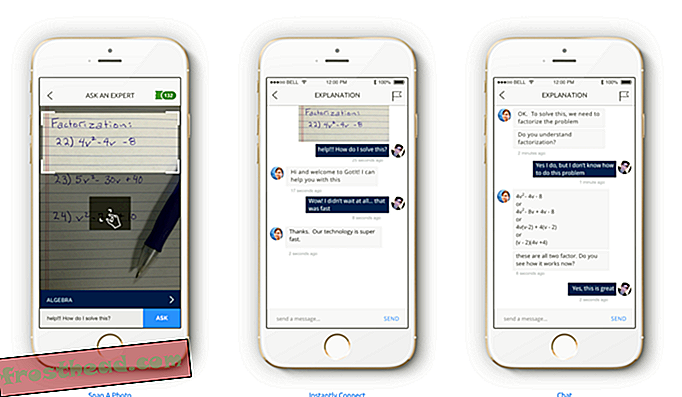

Srovnatelně Avery Thompson poznámky pro Popular Mechanics, Columbia týmová studie se zaměřuje na překlad "zaslechl řeči." Vědci přijali pět epilepsie pacientů, kteří mají podstoupit operaci mozku a požádal je, aby poslouchali řadu mluvených slov - například záznam někoho počítání od nuly do devíti - zatímco je připojeno k monitorovacím zařízením nervů.

Mozkové vlny zachycené těmito nástroji byly vloženy do vokodéru, který syntetizoval řeč pomocí neuronové sítě, která byla podle slov Kristin Houser Futurismem vyškolena, aby „vyčistila“ výstup a učinila zvuky srozumitelnými.

Vědci dále požádali 11 dalších účastníků, aby poslouchali řeč s podporou AI. Je důležité, že spoluautor studie Mesgarani upozorňuje na prohlášení Columbie, že tito jednotlivci byli schopni „porozumět a opakovat“ zvuky kolem 75 procent času - „dobře a dále“ v porovnání s předchozími experimenty. (Nahrávky si můžete posoudit sami zde.)

V rozhovoru s Gizmodovým Dvorským Mesgarani říká, že on a jeho kolegové doufají, že v blízké budoucnosti syntetizují složitější fráze. Vědci také chtějí zaznamenávat mozkové signály generované testovacími subjekty, kteří přemýšlejí nebo představují akt mluvení, spíše než jednoduše poslouchají ostatní. Konečně, Mesgarani dodává v prohlášení, tým si klade za cíl jednoho dne transformovat technologii na implantát schopný převést myšlenky nositele přímo do slov.

Potenciální omezení nového výzkumu zahrnují jeho malou velikost vzorku a podle neurovědce Newcastle University Andrew Jackson, který se studie nezúčastnil, skutečnost, že nervové sítě by musely být zavedeny do obrovského počtu mozkových signálů od každého nového účastníka. aby syntetizoval řeč za čísly nula až devět.

"V budoucnu bude zajímavé sledovat, jak dobře se dekodéry trénované pro jednu osobu zobecňují na jiné osoby, " říká Jackson Gizmodo . "Je to trochu jako systémy včasného rozpoznávání řeči, které si uživatel musel individuálně proškolit, na rozdíl od dnešních technologií, jako jsou Siri a Alexa, které mohou dávat smysl každému hlasu, opět pomocí neuronových sítí." Pouze čas ukáže, zda tyto technologie mohou jednoho dne udělat totéž pro mozkové signály. “