Jak nám Memorial Day připomíná každý rok, válka neodejde.

Ale to se mění. A jeden z hlubších posunů, který uvidíme v následujících letech, je armáda stále více závislá na robotech. Dronovi se nyní dostává nejvíce pozornosti, ale stále více inovací ministerstva obrany jsou další druhy bezpilotních strojů, od experimentálních letadel po vojáky na zemi.

Je snadné pochopit přitažlivost. Používání robotů je potenciálně efektivnější, přesnější a levnější než spoléhat se pouze na lidi ve válce. A samozřejmě by to také znamenalo méně lidských ztrát.

Tato transformace však přináší složitou výzvu: Lze vojenské stroje naprogramovat tak, aby se rozhodovaly? Což vede k naléhavější otázce: Mohou se roboti naučit morálce?

Americký úřad pro námořní výzkum si nyní myslí, že je čas to zjistit. Začátkem tohoto měsíce oznámila pětiletý grant ve výši 7, 5 milionu USD na financování výzkumu na univerzitách Tufts, Brown, Yale a Georgetown a Rensselaer Polytechnic Institute (RPI) o tom, zda si stroje mohou jednoho dne vybrat ze špatného.

Námořnictvo se chce vyhnout situaci, v níž se nyní nachází vozidlo bez řidiče Google: technologie, která je uvolněna daleko před jakýmkoli jasným objasněním právních a etických otázek, které vyvolává. Předtím, než autonomní roboti vyjdou na pole, chce armáda vědět, zda se mohou skutečně naučit dělat správnou věc.

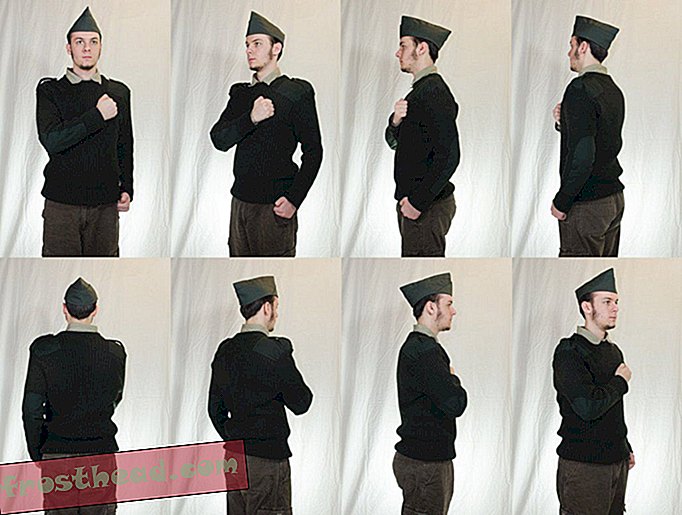

Jak vidí Selmer Bringsjord, vedoucí oddělení kognitivních věd RPI, umělá inteligence robota by mohla být navržena tak, aby fungovala na dvou úrovních morálky. První by byl založen na kontrolním seznamu jasných etických rozhodnutí, jako například „pokud narazíte na zraněného vojáka, měli byste mu pomoci.“ Ale co když tato akce je v rozporu s jejím hlavním posláním, jako je například dodání munice, kterou kriticky potřebuje další vojáci? V tomto bodě, říká Bringsjord, by robot musel mít schopnost zapojit se do „hlubšího morálního uvažování“, aby mohl činit rozhodnutí v situacích, které jeho programátoři nemohli předvídat.

Vědci by museli vyvinout jedinečné algoritmy a výpočetní mechanismy, které by mohly být integrovány do stávající architektury autonomních robotů, což je „proces myšlení“, který by umožnil stroji potlačit plánované chování na základě jeho schopnosti aplikovat morální uvažování.

Pokud se to zdá mimořádně ambiciózní, je to tak. Nejprve budou muset vědci izolovat základní prvky lidské morálky - na jakých zásadách se všichni shodneme? - a pak zjistit, jak je začlenit do algoritmů, které by robotům poskytly určitou úroveň morální kompetence.

To není žádný malý podnik. Z tohoto důvodu je pravděpodobné, že stroje, které nejsou kontrolovány lidmi, budou v dohledné budoucnosti omezeny na nebojové role, jako je dohled, bezpečnost, pátrací a záchranná služba nebo lékařská péče. Ale nevyhnutelně budou vojenští plánovači chtít odpovědět na otázku, která visí nad tím vším: Měli by roboti, kteří jednají sami, mít někdy možnost zabít člověka?

Pokud má stroj 90% jistotu, že každý ve vozidle, který hodlá střílet, je terorista, je to jisté? Mohl by robot vystřelit na dítě zbraň, pokud zjistí, že je to nepřítel? Pokud se něco pokazí a autonomní robot omylem vyhodí vesnici, kdo je za to zodpovědný? Velitel, který nařídil operaci? Osoba, která programovala robota? Nebo nikdo?

Pokud se domníváte, že se jedná stále o sci-fi, zvažte, že začátkem tohoto měsíce na konferenci OSN v Ženevě naváželi odborníci na témata od umělé inteligence po lidská práva až po mezinárodní právo na „zabijáckých robotech“. Skupiny jako Human Rights Watch a úředníci z hrstky zemí, včetně Pákistánu, Egypta, Kuby a Vatikánu, vyzvali k úplnému zákazu robotů s oprávněním zabíjet. Ale většina zemí, zejména ty s nejmodernějšími roboty, není připravena jít tak daleko.

Podívejte se například na WildCat, čtyřnohého robota, který byl vyvinut pro provoz při vysokých rychlostech na všech typech terénu.

Americká armáda prozatím dodržuje směrnici ministerstva obrany z roku 2012, že žádný stroj se schopností zabíjení nemůže být zcela autonomní. Člověk musí doslova nazývat výstřely. To ale nemusí platit pro všechna místa: V březnu citoval nový vědec ruského činitele, který tvrdí, že robotické hlídky v pěti balistických raketových systémech budou schopny detekovat a ničit cíle, aniž by to člověk dal vpřed.

Foster-Miller Talon, viděný níže, je jedním z mnoha strojů na celém světě vyvíjených pro boj.

Pravidla války

Zpráva o konferenci zabijáckých robotů bude předložena Výboru OSN pro určité skryté zbraně v listopadu. Nezdá se však, že by se zákaz objevil brzy.

Mezi účastníky diskuse v Ženevě byl Ronald Arkin, odborník na umělou inteligenci od společnosti Georgia Tech, který je již dlouho zastáncem toho, že dává strojům schopnost provádět morální rozhodnutí. Domnívá se, že pokud se roboti mohou naučit řídit se mezinárodním právem, mohli by se ve válčení chovat etičtěji než lidé, protože by byli nepřekonatelně konzistentní. Nebyli by schopni reagovat hněvem nebo panikou nebo předsudky. Arkin se staví proti zákazu, i když je otevřen moratoriu na autonomní zbraně, dokud stroje nedostanou šanci zjistit, zda mohou ovládnout pravidla války.

Jiný vědec AI, Noel Sharkey, který debatoval o Arkinovi v Ženevě, má velmi odlišnou mysl. Nemyslí si, že by roboti měli mít někdy pravomoc rozhodovat o životě nebo smrti.

Nedávno řekl Defence One : „Nemyslím si, že někdy skončí s morálním nebo etickým robotem. K tomu potřebujeme morální autoritu. Proto musíme ostatním rozumět a vědět, co to znamená trpět. “

"Robot může být nainstalován s některými pravidly etiky, ale to se opravdu nestará, " říká.